|

当前的深度神经网络系统(例如 ChatGPT)很快就能在训练中将能源效率提高 100 倍,“未来的改进将大大提高几个数量级”。来自麻省理工学院和其他机构的科学家展示了一种新的光学神经网络训练方法,可以碾压最先进的电子微处理器。 不仅如此,演示的系统的计算密度也比 Nvidia、Google 或 Graphcore 的系统高出约两个数量级。 基本上,这意味着最先进的模型可以用少一百倍的能量进行训练,在相同的速度下占用更少的空间。

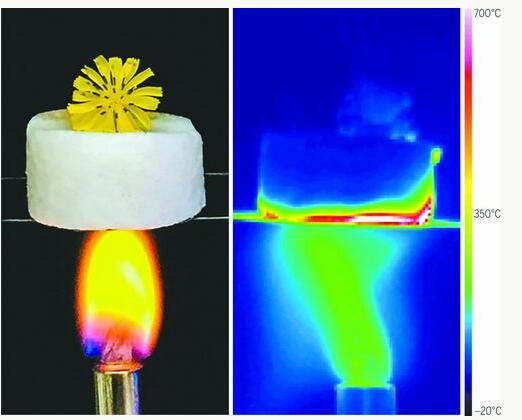

人工神经网络模仿生物大脑处理信息的方式。这些人工智能系统旨在学习、组合和总结大数据集中的信息,正在重塑信息处理领域。当前的应用包括图像、物体、语音识别、游戏、医学和物理化学。 当前的人工智能模型达到了数千亿个人工神经元,呈现出指数级增长,并对当前的硬件能力提出了挑战。 该论文表明,“具有高时钟速率、并行性和低损耗数据传输”的光学神经网络(ONN)方法可以克服当前的局限性。 论文中写道:“我们的技术为大规模光电处理器开辟了一条途径,以加速从数据中心到分散边缘设备的机器学习任务。” ONN 方法有望缓解传统处理器的瓶颈,例如晶体管数量、数据移动能耗和半导体尺寸。ONN 使用光,由于光带宽大和数据传输损耗低,光可以同时携带大量信息。此外,可以集成许多光子电路以扩展系统。 为了移动光线进行计算,麻省理工学院领导的团队利用了许多激光束,该方法被描述为“使用批量制造的微米级垂直腔表面发射激光器进行神经元编码”。 研究人员解释说:“我们的方案类似于生物神经元中的‘轴突-突触-树突’结构。” 他们相信,所演示的系统可以通过成熟的晶圆级制造工艺和光子集成进行扩展。 麻省理工学院电气工程和计算机科学系副教授、这项工作的负责人 Dirk Englund 向 SciTechDaily 解释说,ChatGPT 等模型的大小受到当今超级计算机能力的限制。因此,训练更大的模型在经济上不可行。 他声称:“我们的新技术可以使跨越机器学习模型成为可能,否则在不久的将来是无法实现的。” 这篇题为“使用相干 VCSEL 神经网络进行深度学习”的论文由一个大型科学家团队发表。这项工作得到了陆军研究办公室、NTT Research 和 NTT Netcast 奖的支持,并由大众基金会提供了财政支持。该团队的三名研究人员已申请了与该技术相关的专利。 |

收藏

收藏 打印

打印